rgbdvslam

Localización y mapeo visual simultáneo basado en características (vSLAM) y fusión de sensores visuales-inerciales con cámara RGB-D

Desde R2025a

Descripción

Utilice el objeto rgbdvslam para realizar localización y mapeo visual simultáneo (vSLAM) con datos de cámara RGB-D. RGB-D vSLAM combina información de profundidad de sensores, como cámaras RGB-D o sensores de profundidad, con imágenes RGB para estimar simultáneamente la posición de la cámara y crear un mapa del entorno. Para obtener más información sobre SLAM visual, consulte Implement Visual SLAM in MATLAB (Computer Vision Toolbox).

El objeto rgbdvslam extrae características Oriented FAST y Rotated BRIEF (ORB) de imágenes leídas incrementalmente y luego rastrea esas características para estimar poses de cámara, identificar fotogramas clave y reconstruir un entorno 3D. El algoritmo vSLAM también busca cierres de bucle utilizando el algoritmo de bolsa de características y luego optimiza las poses de la cámara utilizando la optimización del gráfico de poses. Puede mejorar la precisión y la robustez del SLAM integrando este objeto con datos IMU para realizar una fusión de sensores visuales-inerciales.

Creación

Sintaxis

Descripción

vslam = rgbdvslam(intrinsics)vslam, utilizando los parámetros intrínsecos de la cámara especificados.

El objeto rgbdvslam asume que las imágenes de color y profundidad han sido preregistradas con correspondencia uno a uno.

El objeto representa puntos de mapas 3D y poses de cámara en coordenadas mundiales, y asume que la pose de la cámara del primer fotograma clave es una transformación de identidad rigidtform3d (Image Processing Toolbox).

Nota

El objeto rgbdvslam se ejecuta en varios subprocesos internamente, lo que puede retrasar el procesamiento de un cuadro de imagen agregado mediante la función addFrame. Además, el objeto que se ejecuta en varios subprocesos significa que el cuadro actual que el objeto está procesando puede ser diferente del cuadro agregado recientemente.

vslam = rgbdvslam(intrinsics,depthScaleFactor)1.

vslam = rgbdvslam(___,imuParameters)imuParameters especificado.

vslam = rgbdvslam(intrinsics,PropertyName=Value)MaxNumPoints=850 establece el número máximo de puntos de características ORB para extraer de cada imagen en 850.

Argumentos de entrada

Propiedades

Funciones del objeto

addFrame | Agregue un par de imágenes de color y profundidad al objeto SLAM visual RGB-D |

hasNewKeyFrame | Compruebe si se agregó un nuevo fotograma clave en el objeto SLAM visual RGB-D |

checkStatus | Comprobar el estado del objeto SLAM RGB-D visual |

isDone | Estado de fin de procesamiento para el objeto SLAM visual RGB-D |

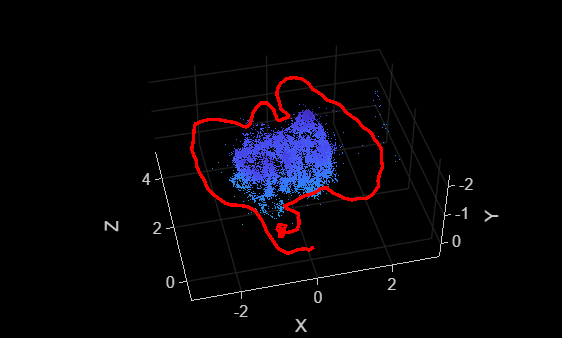

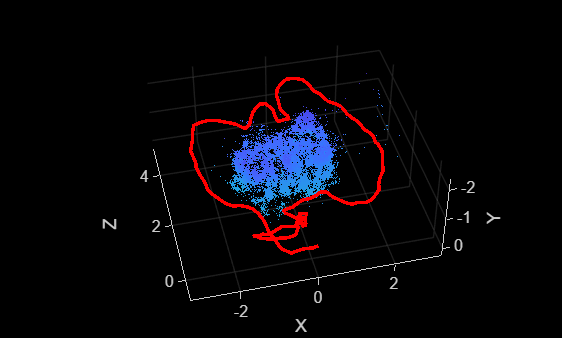

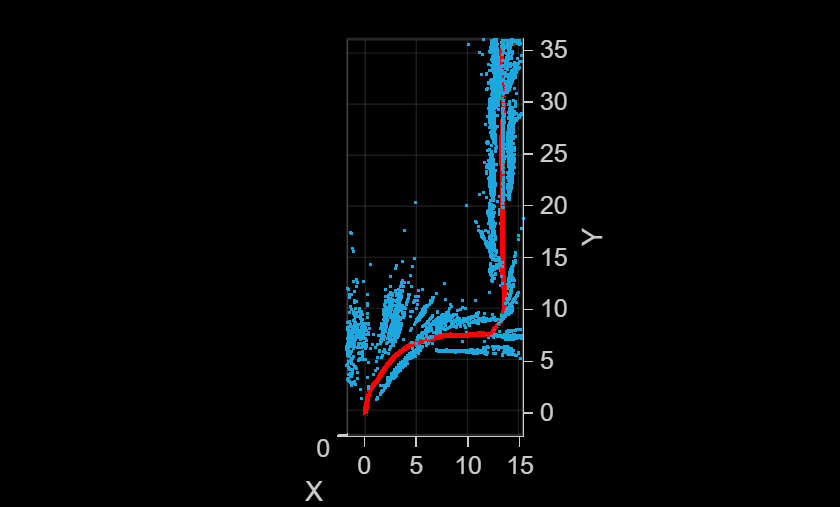

mapPoints | Construya un mapa 3D de puntos del mundo a partir de un objeto vSLAM RGB-D |

poses | Poses absolutas de cámara de fotogramas clave RGB-D vSLAM |

plot | Graficar puntos de mapa 3D y trayectoria estimada de la cámara en SLAM visual RGB-D |

reset | Restablecer el objeto SLAM visual RGB-D |

Ejemplos

Referencias

[1] Mur-Artal, Raul, J. M. M. Montiel, and Juan D. Tardos. “ORB-SLAM: A Versatile and Accurate Monocular SLAM System.” IEEE Transactions on Robotics 31, no. 5 (October 2015): 1147–63. https://doi.org/10.1109/TRO.2015.2463671.

Capacidades ampliadas

Historial de versiones

Introducido en R2025aConsulte también

Objetos

monovslam|factorGraph|factorIMUParameters|cameraIntrinsics(Computer Vision Toolbox) |imageDatastore

Funciones

detectORBFeatures(Computer Vision Toolbox)

Temas

- Implement Visual SLAM in MATLAB (Computer Vision Toolbox)

- Visual SLAM with RGB-D Camera (Computer Vision Toolbox)

- Simulate RGB-D Visual SLAM System with Cosimulation in Gazebo and Simulink (ROS Toolbox)

- Monocular Visual Simultaneous Localization and Mapping (Computer Vision Toolbox)

- Monocular Visual-Inertial SLAM (Computer Vision Toolbox)